A Databricks, empresa de Dados e IA, anunciou hoje o lançamento do DBRX, um modelo de linguagem grande (LLM) de propósito geral que supera todos os modelos open source estabelecidos em benchmarks padrão. O DBRX democratiza o treinamento e ajuste de LLMs personalizados de alto desempenho para todas as empresas, para não precisarem mais depender de um pequeno punhado de modelos fechados.

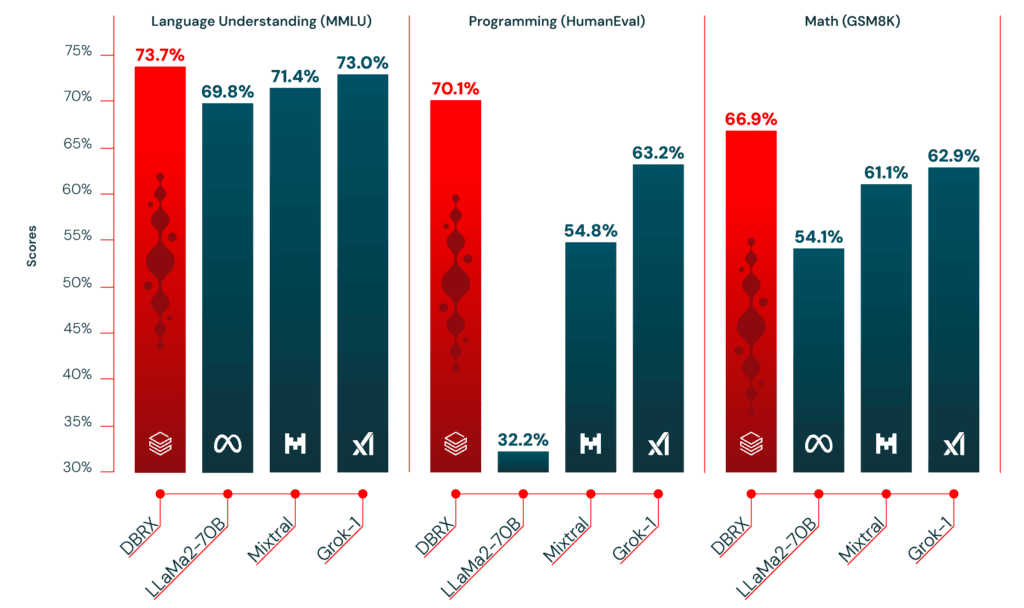

O DBRX supera modelos open source existentes como o Llama 2 70B e o Mixtral-8x7B em benchmarks padrão da indústria, como compreensão de linguagem, programação, matemática e lógica. Ele também supera o GPT-3.5 na maioria dos benchmarks relevantes.

Arquitetura Eficiente

Desenvolvido pela Mosaic AI e treinado na NVIDIA DGX Cloud, o DBRX foi otimizado para eficiência com uma arquitetura de mistura de especialistas (MoE), construída sobre o projeto open source MegaBlocks. O modelo resultante tem desempenho líder e é até duas vezes mais eficiente em termos de computação do que outros LLMs líderes disponíveis.

O DBRX estabelece um novo padrão para modelos open source, permitindo IA generativa personalizável e transparente para todas as empresas. Uma pesquisa recente da Andreessen Horowitz descobriu que quase 60% dos líderes de IA estão interessados em aumentar o uso de open source ou mudar quando modelos open source com ajuste fino correspondem aproximadamente ao desempenho de modelos de código fechado.

Benefícios na Plataforma Data Intelligence

Combinado com as ferramentas unificadas da Databricks Mosaic AI, o DBRX ajuda os clientes a construir e implantar rapidamente aplicativos de IA generativa de qualidade de produção seguros, precisos e governados, sem abdicar do controle de seus dados e propriedade intelectual. Os clientes se beneficiam de recursos integrados de gerenciamento de dados, governança, linhagem e monitoramento na Plataforma Databricks Data Intelligence.

O DBRX está disponível gratuitamente no GitHub e Hugging Face para uso comercial e de pesquisa. A partir de hoje na Plataforma Databricks, as empresas podem interagir com o DBRX, aproveitar seus recursos de contexto longo em sistemas de geração aumentada de recuperação (RAG) e construir modelos DBRX personalizados em seus próprios dados exclusivos.

Com o lançamento do DBRX, a Databricks está permitindo que mais empresas construam modelos de IA generativa seguros, portáteis e de alto desempenho, personalizados para seus próprios dados e casos de uso. Isso deve acelerar a tendência de mudança do uso de modelos fechados para open source no futuro.

Comparativo com outros modelos de llm fechados

| Model | DBRX Instruct | GPT-3.57 | GPT-48 | Claude 3 Haiku | Claude 3 Sonnet | Claude 3 Opus | Gemini 1.0 Pro | Gemini 1.5 Pro | Mistral Medium | Mistral Large |

| MT Bench (Inflection corrected, n=5) | 8.39 ± 0.08 | — | — | 8.41 ± 0.04 | 8.54 ± 0.09 | 9.03 ± 0.06 | 8.23 ± 0.08 | — | 8.05 ± 0.12 | 8.90 ± 0.06 |

| MMLU 5-shot | 73.7% | 70.0% | 86.4% | 75.2% | 79.0% | 86.8% | 71.8% | 81.9% | 75.3% | 81.2% |

| HellaSwag 10-shot | 89.0% | 85.5% | 95.3% | 85.9% | 89.0% | 95.4% | 84.7% | 92.5% | 88.0% | 89.2% |

| HumanEval 0-Shot pass@1 (Programming) | 70.1% temp=0, N=1 | 48.1% | 67.0% | 75.9% | 73.0% | 84.9% | 67.7% | 71.9% | 38.4% | 45.1% |

| GSM8k CoT maj@1 | 72.8% (5-shot) | 57.1% (5-shot) | 92.0% (5-shot) | 88.9% | 92.3% | 95.0% | 86.5%(maj1@32) | 91.7% (11-shot) | 66.7% (5-shot) | 81.0% (5-shot) |

| WinoGrande 5-shot | 81.8% | 81.6% | 87.5% | — | — | — | — | — | 88.0% | 86.7% |

Fonte: Databricks, Yahoo Finance