A Inteligência Artificial (IA), o Machine Learning e o Deep Learning constituem as fronteiras em expansão da tecnologia e da inovação computacional. Esses três termos muitas vezes são confundidos quanto aos seus significados, porém, representam conceitos distintos com aplicações e escopos variados. A IA refere-se à ampla ciência de mimetizar habilidades humanas. Ela abrange tudo que confere aos computadores a capacidade de executar tarefas que, tradicionalmente, requerem inteligência humana.

O Machine Learning, que é um subconjunto da IA, foca em algoritmos que permitem às máquinas aprender a partir de dados e melhorar suas tarefas com a experiência. Os sistemas de Machine Learning utilizam grandes conjuntos de dados para treinar modelos que podem reconhecer padrões, tomar decisões e realizar predições. Esses modelos evoluem de forma autônoma à medida que são expostos a novos dados.

O Deep Learning, por sua vez, é um subconjunto mais especializado do Machine Learning. Utiliza redes neurais artificiais com várias camadas, ou “profundas”, que simulam o funcionamento do cérebro humano para reconhecimento de padrões e tomada de decisão. O Deep Learning é especialmente eficaz para tarefas complexas como processamento de linguagem natural, reconhecimento de fala e visão computacional.

Tabela comparativa entre IA, Machine Learning e Deep Learning

| Característica | IA | Machine Learning | Deep Learning |

|---|---|---|---|

| Escopo | Amplo | Específico | Mais Específico |

| Dados | Diversos | Grandes conjuntos | Grandes conjuntos, alto volume |

| Algoritmos | Baseados em regras | Aprendem com os dados | Redes neurais profundas |

| Tarefas | Genéricas | Definidas | Complexas |

| Aplicações | Chatbots, robótica | Recomendações, análises | Reconhecimento de imagem/voz |

Fundamentos de IA, Machine Learning e Deep Learning

Definição de Inteligência Artificial

A Inteligência Artificial (IA) é o campo de estudo que permite que máquinas simulem habilidades cognitivas humanas. O ponto principal da IA é o desenvolvimento de algoritmos que permitem que máquinas processem dados, aprendam e tomem decisões sem intervenção humana direta. Ela se desdobra em várias técnicas, desde sistemas que seguem regras programadas (conhecidos como hand-coding) até modelos complexos de aprendizado.

Princípios Básicos de Machine Learning

Machine Learning é uma subcategoria da IA que envolve o uso de algoritmos estatísticos para que computadores aprimorem seu desempenho em uma tarefa com base em dados. Há três tipos principais de aprendizado automático:

- Aprendizado supervisionado: O modelo é treinado em um conjunto de dados rotulado e aprende a fazer previsões a partir desse aprendizado.

- Aprendizado não supervisionado: O modelo busca padrões em um conjunto de dados sem rótulos prévios.

- Aprendizado por reforço: O modelo aprende por tentativa e erro, recebendo recompensas ou penalidades por suas ações.

Conceitos e Arquiteturas de Deep Learning

Deep Learning é uma técnica avançada de Machine Learning que utiliza redes neurais profundas com múltiplas camadas de processamento para modelar representações de dados complexas.

As redes neurais são compostas por neurônios artificiais, que imitam as redes neurais biológicas.

Essas redes são capazes de realizar “aprendizado de features” de modo automático, diferentemente de algoritmos mais tradicionais que requerem features manualmente codificadas. Arquiteturas comuns de Deep Learning incluem:

- Redes Neurais Convolucionais (CNNs), utilizadas predominantemente em reconhecimento de imagens.

- Redes Neurais Recorrentes (RNNs), excelentes para processamento de sequências como linguagem natural.

Aplicações e Casos de Uso

As aplicações de Inteligência Artificial, Machine Learning e Deep Learning são vastas e revolucionam como interagimos com tecnologia no cotidiano. Estas ferramentas avançadas transformam grandes volumes de dados em insights, melhoram a interação humano-computador e impulsionam inovações tecnológicas como veículos autônomos.

Aplicações em Big Data

Empresas como Netflix e Amazon utilizam Machine Learning para analisar vastas quantidades de dados gerados por seus usuários. No caso da Netflix, algoritmos de recomendação personalizam o conteúdo exibido para cada usuário, baseando-se em seu histórico e preferências. A Amazon emprega modelos preditivos similares para otimizar suas recomendações de produtos e gerenciamento de estoque.

- Exemplos Práticos:

- Recomendação de filmes e séries (Netflix).

- Sugestões de produtos e otimização de estoque (Amazon).

- Curadoria de playlists personalizadas (Spotify).

Reconhecimento de Imagem e Voz

Os sistemas de reconhecimento de imagem e voz se beneficiam enormemente com os avanços no Deep Learning. Ferramentas como reconhecimento facial são amplamente adotadas em smartphones para autenticação de usuários, enquanto o reconhecimento de objeto é crucial para aplicações como a catalogação automática de fotos.

- Tecnologias Chave:

- Reconhecimento facial para segurança e autenticação.

- Reconhecimento de objetos em sistemas de vigilância.

- Transcrição e análise de fala em chamadas de suporte ao cliente.

Assistentes Virtuais e Chatbots

Assistentes virtuais, como Alexa (Amazon) e Siri (Apple), são exemplos de aplicativos práticos de IA em interações por voz. Eles exemplificam como o reconhecimento de fala e o processamento de linguagem natural podem entender e responder ao usuário de forma eficiente e humanizada.

- Implementações Notáveis:

- Alexa para gestão de dispositivos domésticos inteligentes.

- Siri como assistente pessoal em dispositivos móveis.

- Chatbots em atendimento ao cliente para resoluções rápidas de questões.

Veículos Autônomos e Robótica

A robótica e os carros autônomos representam a fronteira da aplicação da IA, combinando reconhecimento de imagem, sensores e algoritmos de decisão para navegação independente. Carros autônomos estão avançando rapidamente, com testes e aplicações práticas sendo desenvolvidos por empresas especializadas e fabricantes de automóveis.

- Desenvolvimentos Atuais:

- Carros autônomos utilizando sensores e IA para dirigir sem intervenção humana.

- Robôs colaborativos em cadeias de produção que aumentam a eficiência operacional.

Tecnologia e Ferramentas

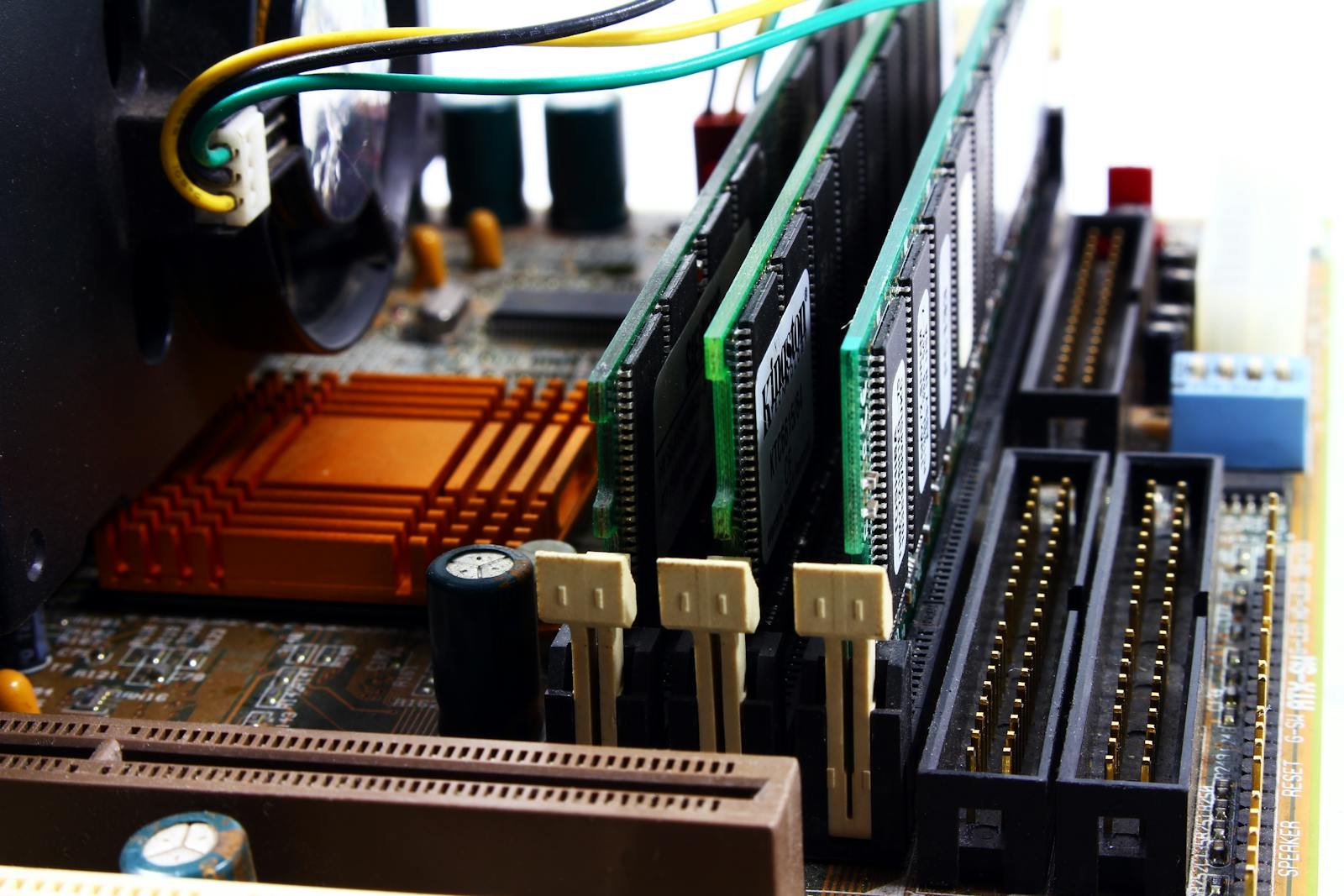

Hardware para IA

Na área de inteligência artificial, a escolha de hardware é um fator crítico que impacta diretamente no desempenho dos algoritmos. Processadores gráficos (GPUs) são especialmente relevantes em tarefas de deep learning, devido à sua capacidade de realizar operações de ponto flutuante em paralelo, acelerando significativamente o processamento de redes neuronais. Por outro lado, Unidades de Processamento Central (CPUs) são utilizadas para tarefas que não se beneficiam tanto da paralelização, mas exigem operações sequenciais otimizadas.

- CPU: Indicado para tarefas de gerenciamento de dados e algoritmos que não exigem alto paralelismo.

- GPU: Ideal para acelerar o treino de redes neuronais, processamento de grandes conjuntos de dados e tarefas intensivas em cálculos matemáticos.

Algoritmos e Estruturas de Dados

Os algoritmos formam a espinha dorsal do aprendizado de máquina e do deep learning. A escolha adequada dos algoritmos e das estruturas de dados é crucial para o sucesso da modelagem de IA. Estruturas de dados otimizadas permitem melhorar a eficiência do armazenamento e do acesso aos dados durante o treinamento dos modelos.

- Algoritmos: Classificadores, regressores e redes neuronais convolucionais.

- Estruturas de Dados: Arrays multidimensionais, árvores de decisão e grafos.

Redes Neurais e GPUs

Redes neuronais são um tipo de modelo de deep learning inspirado no funcionamento do cérebro humano. São compostas de camadas de neurônios artificiais que processam dados de entrada para realizar tarefas complexas. As GPUs desempenham um papel fundamental ao acelerar a computação necessária para treinar redes neuronais. O uso de GPUs otimiza o fluxo de operações matemáticas, resultando em um processo de treinamento muito mais rápido e eficaz.

- Redes Neuronais: Incluem arquiteturas como redes neuronais convolucionais (CNNs) e redes neuronais recorrentes (RNNs).

- GPUs: Ferramentas chave para processamento paralelo, reduzindo significativamente o tempo de treinamento das redes.

Desenvolvimento e Aprendizado em AI

Aprendizado Supervisionado

No Aprendizado Supervisionado, os algoritmos são treinados em um conjunto de dados rotulados. O objetivo é aprender uma função que, dada uma entrada, pode prever a saída correspondente. Aplicações típicas incluem:

- Classificação: Por exemplo, a utilização de Árvores de Decisão (decision trees) para diferenciar emails como “spam” ou “não spam”.

- Regressão: Uso de métodos como Máquinas de Vetores de Suporte (support vector machine) para prever valores contínuos, como o preço de casas baseado em suas características.

Algoritmos Comuns:

- Árvores de Decisão

- Naive Bayes

- Random Forest

- K-Vizinhos Mais Próximos (k-nearest neighbor)

- Máquinas de Vetores de Suporte

Aprendizado Não Supervisionado

No Aprendizado Não Supervisionado, os modelos são apresentados a dados sem etiquetas e devem encontrar padrões e relações por conta própria. Técnicas comuns são:

- Agrupamento: Onde o algoritmo tenta agrupar dados em subconjuntos semelhantes sem nenhuma supervisão prévia.

- Redução de Dimensionalidade: Que visa simplificar os dados sem perder informações importantes, facilitando o reconhecimento de padrões.

Exemplos de Algoritmos:

- Análise de Componentes Principais (Principal Component Analysis – PCA)

- Algoritmos de Agrupamento, como K-Means

Aprendizado por Reforço

Aprendizado por Reforço envolve treinar um agente de IA através de um sistema de recompensas e penalidades. O agente aprende a tomar decisões baseando-se no resultado de suas ações anteriores para maximizar algum conceito de recompensa cumulativa. O Reconhecimento de Padrões é um elemento importante, e esse tipo de aprendizado é frequentemente aplicado em jogos de estratégia, robótica e navegação.

Aspectos Importantes:

- O desenvolvimento de políticas de decisão

- O balanceamento entre a exploração de novas ações e a exploração das recompensas já conhecidas

- Usos de algoritmos como Q-Learning e Deep Q-Networks (DQN)

Arquitetura e Modelagem em Deep Learning

Deep Learning representa um ramo avançado da Inteligência Artificial que explora redes neurais profundas para realizar tarefas complexas, como reconhecimento de voz e imagem. Tais redes são desenhadas para simular o funcionamento do cérebro humano através de múltiplas camadas de processamento.

Redes Neurais Convolucionais

Redes Neurais Convolucionais (CNNs) são algoritmos de Deep Learning que se mostram eficientes na análise visual de imagens. Elas utilizam camadas convolucionais para automaticamente e eficazmente realizar a extração de características sem a necessidade de intervenção manual. A arquitetura típica de uma CNN contém diversas camadas, incluindo:

- Camadas convolucionais: aplicam filtros que convoluem sobre a imagem para detectar padrões.

- Camadas de pooling: reduzem a dimensionalidade espacial para diminuir a complexidade computacional.

- Camadas totalmente conectadas: funcionam para classificar os recursos extraídos das camadas anteriores.

Redes Neurais Artificiais

As Redes Neurais Artificiais (ANNs) são a base das redes de Deep Learning e são inspiradas pela rede neural biológica do cérebro humano. Uma ANN padrão inclui:

- Camada de entrada: recebe o sinal de entrada.

- Camadas ocultas: processam os sinais através de nós ou neurônios.

- Camada de saída: fornece a decisão ou previsão final baseada nos sinais processados.

O número de neurônios nessas camadas varia de acordo com a complexidade da tarefa a ser aprendida pela rede.

Otimização e Extração de Características

A otimização em Deep Learning mira na melhoria contínua do desempenho do modelo durante o treinamento. Métodos de otimização comuns incluem:

- Gradiente descensurado (como o Stochastic Gradient Descent – SGD)

- Momentum

- Adaptativos (como o Adam e o RMSprop)

A extração de características é uma etapa crítica em que as redes neurais identificam atributos importantes que são mais significativos para realizar previsões ou classificações. Em Deep Learning, essa extração é geralmente aprendida automaticamente pelo modelo ao longo do processo de treinamento, resultando em um desempenho superior em tarefas complexas de reconhecimento de padrões.

Desafios e Tendências Futuras

A Inteligência Artificial (IA), Machine Learning (ML) e Deep Learning (DL) estão em constante evolução, enfrentando desafios e moldando as próximas inovações tecnológicas. Esta seção explora os limites atuais e as expectativas futuras dessas tecnologias.

Limitações e Desafios Atuais

A IA, ML e DL têm um conjunto específico de limitações que os desenvolvedores e pesquisadores buscam superar. Algorítmos tradicionais de Machine Learning requerem grandes quantidades de dados rotulados para treinamento, o que nem sempre é viável ou disponível. Além disso, sistemas como o Deep Blue e o AlphaGo demonstram capacidades impressionantes em ambientes e jogos estruturados, porém eles ainda lutam para lidar com situações do mundo real que apresentam incertezas e variabilidades.

Capacidades e Limitações:

- Robustez: IA e ML podem falhar diante de exemplos adversários ou dados corrompidos.

- Generalização: A habilidade de generalizar a partir de dados de treinamento para situações novas permanece um obstáculo.

A tecnologia enfrenta também questões éticas, como a transparência na tomada de decisões e os viéses inseridos durante o treinamento dos algoritmos.

- Transparência: A caixa-preta em modelos de DL é uma preocupação.

- Viés: Machine learning pode perpetuar ou amplificar viéses existentes nos dados.

No campo da robótica, desafios incluem a criação de robôs que possam operar de forma autônoma em ambientes complexos e interagir de maneira segura e eficaz com seres humanos.

Visão de Futuro e Inovações

O futuro da IA, ML e DL aponta para uma expansão nas capacidades e uma resolução gradual de suas limitações. A intersecção de IA com outras áreas, como nanotecnologia e genômica, promete inovações revolucionárias. Espera-se que algoritmos de ML se tornem mais eficientes, reduzindo a necessidade de grandes conjuntos de dados e energia para treinamento.

Inovações Previstas:

- Autonomia: Desenvolvimento de AI systems com maior grau de autonomia e capacidade de aprendizado sem supervisão.

- Interdisciplinaridade: Fusão da IA com outras ciências potencializará novas aplicações.

Uma ênfase na compreensão do cérebro humano e seus processos pode levar a algoritmos mais avançados de DL que imitem mais precisamente o funcionamento cognitivo humano. Este progresso alavancará robótica e sistemas inteligentes para novas alturas, possivelmente permitindo interações complexas entre humanos e máquinas que hoje parecem distantes.

Segue um vídeo abaixo resumindo as diferenças.