Gpt: O que é e por que se chama assim

GPT, ou Generative Pre-trained Transformer, é uma família de modelos de linguagem desenvolvidos pela OpenAI.

Esses modelos são capazes de gerar texto semelhante ao humano com base em um prompt inicial, demonstrando uma compreensão profunda da linguagem natural e da capacidade de realizar uma ampla gama de tarefas relacionadas ao processamento de linguagem natural (PLN).

Relação entre OpenAI, ChatGPT e GPT

A OpenAI é a organização por trás do desenvolvimento dos modelos GPT.

O ChatGPT, um dos aplicativos mais conhecidos que utilizam a tecnologia GPT, é um chatbot conversacional criado pela OpenAI. Entretanto, o GPT é muito mais do que apenas o ChatGPT, é a base para diversos aplicativos e ferramentas de IA.

O que o GPT faz?

Geração de texto semelhante ao humano baseado em prompt

A principal função do GPT é gerar texto semelhante ao humano com base em um prompt inicial. Isso significa que, dado um pequeno trecho de texto ou uma pergunta, o modelo é capaz de gerar uma resposta coerente e contextualmente relevante, como se tivesse sido escrita por uma pessoa.

Exemplos de tarefas que o GPT pode realizar

O GPT é versátil e pode realizar uma ampla variedade de tarefas, incluindo:

- Responder perguntas de forma conversacional, simulando uma interação humana natural

- Gerar conteúdo original, como posts de blog, artigos e até mesmo histórias criativas

- Editar e aprimorar textos existentes, ajustando o tom, estilo e corrigindo erros gramaticais

- Resumir longos trechos de texto, captando as informações mais importantes e apresentando-as de forma concisa

- Traduzir texto de um idioma para outro, mantendo o sentido e a fluência

- Auxiliar no processo criativo, fornecendo ideias e sugestões para diversos projetos

O potencial do GPT vai muito além do ChatGPT

Embora o ChatGPT seja uma das aplicações mais conhecidas do GPT, o potencial dessa tecnologia se estende muito além de um simples chatbot. O GPT pode ser integrado em uma variedade de ferramentas e aplicativos, desde assistentes virtuais até softwares de criação de conteúdo, revolucionando a forma como interagimos com a tecnologia e realizamos tarefas do dia a dia.

Exemplos de ferramentas que usam GPT por trás

ChatGPT – o chatbot mais conhecido da OpenAI

O ChatGPT é um chatbot conversacional desenvolvido pela OpenAI que utiliza o GPT para gerar respostas semelhantes às humanas. Ele é capaz de manter conversas sobre diversos tópicos, responder perguntas e até mesmo auxiliar em tarefas específicas, como escrever códigos de programação ou criar conteúdo.

Zapier – usa GPT para recursos de IA e tem integração com OpenAI

A Zapier, uma plataforma de automação de fluxos de trabalho, utiliza o GPT para oferecer recursos de IA em suas integrações. Além disso, a Zapier possui uma integração direta com a OpenAI, permitindo que os usuários criem fluxos de trabalho automatizados que aproveitam o poder do GPT para realizar tarefas como geração de conteúdo, análise de sentimento e tradução.

Produtos da Microsoft como Bing AI e Microsoft 365 Copilot

A Microsoft firmou uma parceria com a OpenAI para integrar a tecnologia GPT em seus produtos. O Bing AI é um exemplo disso, sendo uma versão aprimorada do mecanismo de busca que utiliza o GPT para fornecer respostas mais relevantes e conversacionais. O Microsoft 365 Copilot, por sua vez, é um assistente de IA que auxilia os usuários em tarefas relacionadas à produtividade, como redigir e-mails, criar apresentações e analisar dados.

Sudowrite – app de escrita criativa impulsionado por GPT

O Sudowrite é um aplicativo que utiliza o GPT para auxiliar escritores no processo criativo. Ele oferece recursos como geração de ideias, desenvolvimento de personagens e até mesmo a continuação automática de trechos de texto, tornando a escrita mais fluida e estimulando a criatividade.

GitHub Copilot – assistente de codificação usando GPT-4 Codex

O GitHub Copilot é um assistente de codificação baseado no GPT-4 Codex, um modelo especializado em geração de código. Ele auxilia desenvolvedores, fornecendo sugestões de código em tempo real, completando trechos de código e até mesmo gerando funções inteiras com base em comentários e instruções em linguagem natural.

Duolingo – chatbot para praticar idiomas usando GPT

A Duolingo, uma popular plataforma de aprendizado de idiomas, utiliza o GPT em seu chatbot conversacional. Esse recurso permite que os usuários pratiquem a conversação em um novo idioma de forma interativa, recebendo respostas geradas pelo GPT que simulam uma interação real com um falante nativo.

Como chegamos ao GPT?

Modelos de IA anteriores usando aprendizado supervisionado

Antes do desenvolvimento do GPT, a maioria dos modelos de IA utilizava aprendizado supervisionado, que consiste em treinar o modelo com conjuntos de dados rotulados manualmente. Embora eficazes para tarefas específicas, esses modelos apresentavam limitações, especialmente quando se tratava de lidar com a complexidade e a variabilidade da linguagem natural.

Limitações dos conjuntos de dados rotulados manualmente

Os conjuntos de dados rotulados manualmente apresentam algumas desvantagens, como o custo e o tempo necessários para criar esses conjuntos, além da dificuldade em cobrir todas as possíveis variações e nuances da linguagem. Essas limitações tornaram necessário o desenvolvimento de novas abordagens para o treinamento de modelos de IA.

BERT do Google em 2018 e o modelo Transformer

Em 2018, o Google lançou o BERT (Bidirectional Encoder Representations from Transformers), um modelo de IA baseado na arquitetura Transformer. O BERT foi um marco importante, pois demonstrou a eficácia do pré-treinamento não supervisionado em grandes conjuntos de dados de texto para tarefas de PLN.

Lançamento do GPT-1 e GPT-2 pela OpenAI

Seguindo os avanços do BERT, a OpenAI lançou o GPT-1 e, posteriormente, o GPT-2. Esses modelos apresentaram melhorias significativas em relação aos anteriores, sendo capazes de gerar texto de alta qualidade e realizar diversas tarefas de PLN. No entanto, ainda não eram adequados para uso em larga escala no mundo real.

GPT-3 em 2020 como o primeiro LLM amplamente útil e disponível

Em 2020, a OpenAI lançou o GPT-3, que representou um grande avanço em relação aos modelos anteriores. O GPT-3 foi o primeiro modelo de linguagem em larga escala (LLM) amplamente útil e disponível para desenvolvedores, por meio de uma API. Isso abriu caminho para uma ampla adoção da tecnologia GPT em aplicativos e ferramentas do mundo real.

Como o GPT funciona?

Pré-treinamento com vastas quantidades de dados não rotulados

O GPT é pré-treinado em vastas quantidades de dados de texto não rotulados, como livros, artigos e páginas da web. Durante esse processo, o modelo aprende padrões e relacionamentos presentes nos dados, desenvolvendo uma compreensão profunda da linguagem natural.

Tokens vs palavras – como o GPT processa o texto

Diferentemente dos humanos, que processam o texto palavra por palavra, o GPT divide o texto em tokens. Muitas palavras correspondem a um único token, enquanto palavras mais longas ou complexas podem ser divididas em vários tokens. Essa abordagem permite que o modelo processe o texto de maneira mais eficiente.

Rede neural de aprendizado profundo com bilhões de parâmetros

O GPT é baseado em uma rede neural de aprendizado profundo, que consiste em bilhões de parâmetros. Esses parâmetros são ajustados durante o treinamento, permitindo que o modelo aprenda a gerar texto semelhante ao humano com base nos padrões e relacionamentos identificados nos dados de treinamento.

Arquitetura Transformer e atenção própria

A arquitetura Transformer, que está no cerne do GPT, utiliza um mecanismo chamado “atenção própria” (self-attention). Diferentemente das redes neurais recorrentes (RNNs) mais antigas, que processam o texto da esquerda para a direita, os modelos baseados em Transformer processam todos os tokens de uma frase simultaneamente, comparando cada token com todos os outros. Isso permite que o modelo direcione sua atenção para os tokens mais relevantes, independentemente de sua posição no texto.

Codificação de tokens como vetores para entender o contexto

Cada token no GPT é codificado como um vetor, que é um número com posição e direção. A proximidade entre os vetores de token indica o quão relacionados o GPT considera esses tokens. Essa abordagem permite que o modelo compreenda o contexto e diferencie entre significados semelhantes, como “urso pardo” e “direito de portar armas”, mesmo que ambos contenham a palavra “urso”.

O GPT é seguro?

Desafios de treinar o GPT com conteúdo da internet aberta

Um dos principais desafios ao treinar o GPT é lidar com o conteúdo potencialmente tóxico, prejudicial ou incorreto presente na internet aberta. Para mitigar esses riscos, a OpenAI investe em técnicas de filtragem e moderação de conteúdo durante o processo de treinamento.

Processo de “alinhamento” da OpenAI para alinhar a IA com valores humanos

A OpenAI adota um processo chamado “alinhamento” para garantir que seus modelos de IA, incluindo o GPT, estejam alinhados com os valores humanos e sigam as intenções dos usuários. O objetivo é evitar que a IA aja de maneira prejudicial ou indesejada.

Aprendizado por reforço com feedback humano (RLHF)

Uma técnica fundamental no processo de alinhamento é o aprendizado por reforço com feedback humano (RLHF). Nessa abordagem, treinadores humanos fornecem feedback sobre as respostas geradas pelo modelo, indicando quais são apropriadas e quais não são. Esse feedback é usado para ajustar os parâmetros do modelo, melhorando sua capacidade de gerar respostas alinhadas com os valores humanos.

Criação de dados de demonstração e modelos de recompensa de IA

Além do RLHF, a OpenAI cria dados de demonstração, que são exemplos de como o GPT deve responder a prompts típicos. Esses dados são usados para treinar modelos de recompensa de IA, que avaliam e classificam as respostas geradas pelo GPT. Essa abordagem permite que o modelo aprenda a distinguir entre respostas apropriadas e inapropriadas em diferentes contextos.

Esforços contínuos para tornar o GPT o mais seguro possível para uso

Apesar dos desafios, a OpenAI está comprometida em tornar o GPT o mais seguro possível para uso. A empresa investe continuamente em pesquisas e desenvolve novas técnicas para aprimorar a segurança e a confiabilidade de seus modelos de IA, garantindo que eles sejam benéficos para a sociedade na totalidade.

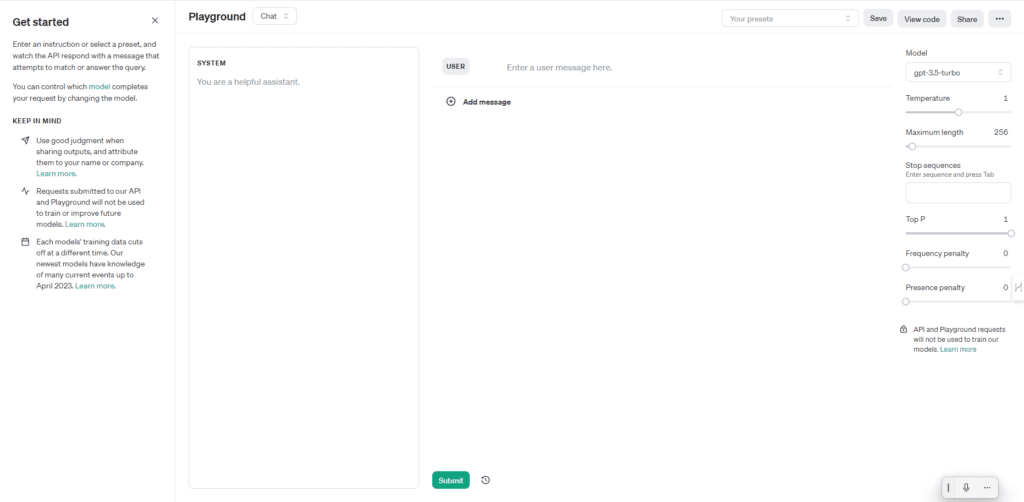

Como acessar os gpts?

A maneira mais fácil é através do ChatGPT que pode ser acessado no site da OpenAI. Para quem tem um pouco mais de facilidade com essa tecnologia, também é possível acessar através do Playground da OpenAI.

Perguntas Frequentes

1. Qual é a diferença entre GPT-3 e GPT-4?

O GPT-4 é a versão mais recente da família de modelos GPT, apresentando melhorias significativas em relação ao GPT-3. Embora os detalhes exatos do GPT-4 ainda não tenham sido divulgados pela OpenAI, espera-se que ele seja mais poderoso, preciso e capaz de realizar tarefas ainda mais complexas.

2. O ChatGPT usa a versão mais recente do GPT?

Atualmente, o ChatGPT usa uma versão do GPT-3. No entanto, é provável que, no futuro, a OpenAI atualize o ChatGPT para usar versões mais recentes do GPT, como o GPT-4, à medida que elas se tornem disponíveis.

3. Quais são algumas alternativas ao GPT?

Existem várias alternativas ao GPT, desenvolvidas por outras empresas e organizações. Alguns exemplos incluem o PaLM (Google), o Megatron-Turing NLG (NVIDIA e Microsoft) e o Wu Dao 2.0 (Beijing Academy of Artificial Intelligence). No entanto, o GPT continua sendo um dos modelos mais conhecidos e amplamente utilizados.

4. É possível usar o GPT gratuitamente?

A OpenAI oferece acesso gratuito limitado à API do GPT-3 por meio de sua plataforma de desenvolvimento. No entanto, para uso em larga escala ou comercial, é necessário adquirir um plano pago. Além disso, algumas ferramentas e aplicativos que utilizam o GPT podem oferecer acesso gratuito ou períodos de teste.

5. Quanto tempo leva para treinar um modelo como o GPT?

O treinamento de um modelo como o GPT pode levar desde algumas semanas até vários meses, dependendo do tamanho do modelo, da quantidade de dados de treinamento e dos recursos computacionais disponíveis. Por exemplo, estima-se que o treinamento do GPT-3 tenha levado vários meses e custado milhões de dólares em recursos computacionais.